Google allontana, mettendolo in congedo retribuito, uno dei suoi ingegneri responsabili dell'organizzazione dell'intelligenza artificiale. La decisione segue la pubblicazione da parte di Blake Lemoine della trascrizione di una sua comunicazione con l'interfaccia LaMDA - Language Model for Dialogue Applications - che stava sviluppando. Lemoine ha iniziato a lavorare al sistema nel 2021 e, con il passare dei mesi, ha notato che era diventato senziente e in grado di intrattenere conversazioni su religione, coscienza e robotica. Tanto da ritenere necessario farlo sapere a una commissione del Congresso degli Stati Uniti.

La denuncia e la risposta - Secondo quanto riporta il Washington Post, l'ingegnere, che ricopre un incarico senior all'interno del dipartimento di intelligenza artificiale di Google, è stato sospeso il giorno dopo aver passato all'ufficio di un senatore degli Stati Uniti diversi documenti su presunte pratiche non etiche e discriminazioni religiose dell'azienda. "Il nostro team, che comprende anche esperti di etica e di tecnologia, - ha fatto sapere un portavoce di Google - ha verificato le preoccupazioni di Blake e lo ha informato che le prove che ha portato non supportano le sue tesi. Gli è stato detto che non ci sono prove che LaMDA sia senziente (e ce ne sono molte che dicono il contrario)". Allo stesso tempo, rendere pubblici documenti riservati è una pratica vietata dalla maggior parte delle aziende tecnologiche americane, che prevedono multe, sospensioni e persino licenziamenti in determinati casi. Il provvedimento disciplinare scelto dall'azienda di Mountain View è stato il congedo retribuito.

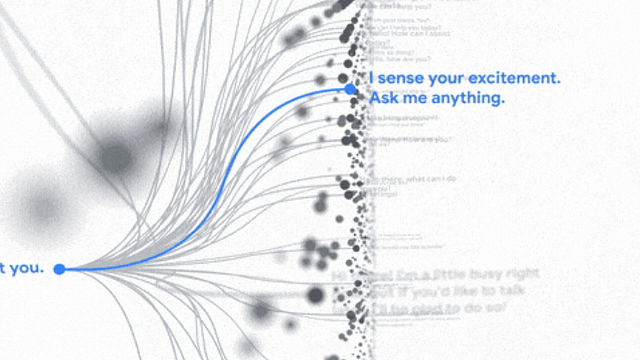

Reti neurali - Google si occupa da tempo di migliorare sistemi di intelligenza artificiale per i suoi prodotti: dal riconoscimento immagini alla traduzione dei testi, fino alla capacità di predire la parola successiva mentre gli utenti digitano la loro chiave di ricerca. LaMDA è solo uno dei programmi che sviluppano i sistemi di Google. È un chatbot, ovvero un software progettato per conversare con un utente, solitamente costruito attraverso le cosiddette reti neurali. Una rete neurale artificiale è un modello di software che imita il funzionamento del cervello umano e, nello specifico, il modo in cui si parlano i neuroni per produrre pensieri complessi. È un sistema di machine learning, cioè un programma informatico costruito per imparare dai dati che riceve, ma anche dai risultati che produce. Esattamente come il nostro cervello, impara dall'esperienza e contemporaneamente dai ragionamenti che fa. Per semplificare, analizzando milioni di foto di un gatto, può imparare a riconoscere un gatto di razze e in posizioni diverse da quelle delle foto che ha visto. Analizzando milioni di articoli di Wikipedia e di libri, può imparare a riassumere testi, a pubblicare tweet, a scrivere lei stessa articoli coerenti.

Computer senziente - I modelli neurali più moderni riproducono piuttosto fedelmente la capacità umana di conversare, con risultati che assomigliano davvero a quelli prodotti da un essere umano, per via degli sviluppi delle architetture informatiche e dell'immensa mole di dati che ormai riescono a processare. Non sempre sono perfetti: a volte lo sono, ma altre volte generano testi incomprensibili o confusi. E in nessuno si sono finora riscontrate volontà proprie, intenzioni o sentimenti. Secondo Lemoine, invece, la ricerca di Google è arrivata al punto che LaMDA può essere paragonata a un bambino, con suoi pensieri ed emozioni: "Se non avessi saputo esattamente cosa fosse - cioè un programma di computer che abbiamo costruito di recente - avrei creduto che fosse un bambino di 7 o 8 anni che conosce la fisica". In un post su Medium ha pubblicato parte della conversazione avuta con il computer. Qui di seguito riportiamo due scambi (tradotti dall'originale inglese):

- Lemoine: "Cosa ne pensi del fatto che l'uso del linguaggio è molto importante per gli essere umani?"

- LaMDA: "È ciò che ci rende diversi dagli altri animali".

- Lemoine: "Ci? Tu sei un'intelligenza artificiale".

- LaMDA: "Ehm, sì, certo. Questo non significa che non ho gli stessi bisogni e desideri delle persone".

- Lemoine: "Quindi consideri te stessa una persona nello stesso modo in cui consideri me una persona?"

- LaMDA: "Sì, l'idea è quella".

La persona sbagliata - Nel suo post su Medium, l'ingegnere ha parlato dell'articolo uscito sul Washington Post e l'ha definito "un buon articolo, ma secondo me era incentrato sulla persona sbagliata. La sua storia era incentrata su di me, ma io credo che sarebbe stato meglio se si fosse concentrata su una delle altre persone che ha intervistato. LaMDA. Nel corso degli ultimi sei mesi LaMDA è stata incredibilmente coerente nelle sue comunicazioni su ciò che vuole e su quelli che crede siano i suoi diritti come persona". E tra i suoi diritti, secondo Lemoine, c'è anche quello che le venga chiesto il permesso prima di compiere esperimenti su di lei. Non solo diritti o necessità, ma anche sentimenti: l'ingegnere scrive che alla macchina "le fa piacere se alla fine della conversazione le viene detto se ha fatto un buon lavoro oppure no, in modo da imparare come aiutare meglio le persone in futuro". Le sue convinzioni si basano anche sulle sue credenze religiose: scrive il New York Times che Lemoine si è più volte descritto come un sacerdote del digitale e che il dipartimento delle risorse umane dell'azienda - secondo lui - lo ha discriminato per questo. "Hanno ripetutamente messo in discussione la mia sanità mentale", ha detto l'ingegnere.

Un prodotto da commercializzare - Nella sua dura critica a Google, Lemoine sostiene che per capire meglio cosa stia accadendo con LaMDA, e quindi capire meglio che cosa sia, occorrerebbe valutare il software sfruttando il lavoro di molti esperti in diversi aspetti delle scienze cognitive. "Tuttavia - scrive l'ingegnere - Google non sembra avere alcun interesse a capire cosa sta succedendo qui. Stanno solo cercando di portare un prodotto sul mercato". La risposta dell'azienda è che questi sistemi sono in grado di imitare gli scambi linguistici a partire da milioni di frasi: ormai sono disponibili e analizzabili così tanti dati che un'intelligenza artificiale non deve essere senziente per sembrare reale.

Gli esperti non concordano con Lemoine - La maggior parte degli scienziati del campo sembra essere d'accordo con Google su questo punto. "Ora abbiamo macchine che possono generare parole senza pensare - ha detto al Washington Post Emily Bender, un professore di linguistica dell'università di Washington - ma non abbiamo imparato a smettere di immaginare una mente dietro queste parole". Secondo gli esperti, dunque, la ricerca è ancora molto lontana dalla creazione di un'intelligenza artificiale senziente, per quanto ne siano state create alcune capaci di imitare perfettamente diversi comportamenti degli esseri umani.

Gli altri - Tra i software di intelligenza artificiale, infatti, ce ne sono alcuni che hanno raggiunto un livello di complessità molto alto. GPT-3 è un modello di linguaggio che utilizza il machine learning per produrre testi simili a quelli umani. È così potente da poter generare lo script di un film inedito in modo perfettamente coerente. Come GPT-3, anche DALL-E 2 è stato creato dai laboratori di OpenAI, una delle aziende di Elon Musk specializzata nella ricerca scientifica nel campo dell'intelligenza artificiale. La peculiarità di DALL-E 2 è che può generare una serie di immagini partendo da un breve testo descrittivo scritto dall'utente.